网易有道公司近日正式宣布,其自主研发的「超感跨模态算法」(Super-sense Cross-modal Algorithm)已成功实现商业化应用,并全面搭载于有道翻译等核心产品中。这项革新技术是行业内首个真正实现图像、文本、音频和语义(图文音义)在单一模型内统一理解和生成的解决方案。它旨在从根本上解决传统翻译模型仅处理文本的局限性,通过模拟人类综合感知世界的方式,为用户带来前所未有的精准、智能且符合真实场景的翻译体验。

文章目录

- 什么是「超感跨模态算法」?一场颠覆传统翻译的革命

- 突破瓶颈:「超感跨模态算法」解决了哪些传统翻译难题?

- 技术揭秘:有道「子曰」大模型如何驱动这一创新?

- 实践出真知:新算法已在哪些有道产品中落地?

- 展望未来:跨模态技术将如何重塑AI翻译的版图?

什么是「超感跨模态算法」?一场颠覆传统翻译的革命

长期以来,机器翻译(MT)主要在文本的维度上进行优化,即从一种语言的文字转换成另一种语言的文字。然而,人类的交流远不止于文字。我们通过视觉、听觉和上下文共同理解信息。网易有道推出的「超感跨模态算法」正是为了弥合这一差距,它标志着AI翻译从单一的语言处理,迈向了更高级的、类似人类的综合感知阶段。

从“翻译文本”到“理解世界”:核心理念解析

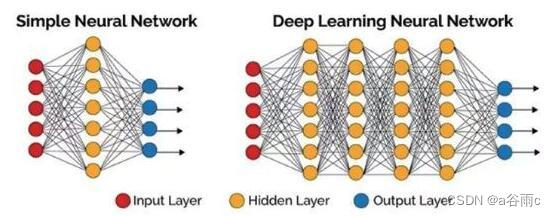

“跨模态”(Cross-modal)是理解这项技术的核心。它指的是人工智能系统能够同时处理和理解来自不同“模态”(即信息格式)的数据,例如文本、图像和声音。传统翻译模型是单模态的,它无法理解一张图片或一段音频的上下文。而有道的「超感跨模态算法」则不同,它能够像人一样,看到一张带有文字的图片时,不仅识别文字,还能理解图片中的场景,从而给出更贴切的翻译。这是一种从“翻译孤立的文本”到“理解信息所处的完整世界”的根本性转变。

为何说它是行业首个“图文音义统一”模型?

“统一”是这项技术的另一大亮点。在此之前,一些应用或许通过“模型串联”的方式实现类似功能:先用一个AI模型进行光学字符识别(OCR),再将识别出的文本送入另一个翻译模型。这种方式不仅效率低下,而且在信息传递过程中容易出错和失真。有道的「超感跨模态算法」则采用端到端(End-to-End)的统一模型架构,将图像、文本、音频等输入信息直接在一个模型内部进行融合、理解和处理,最终生成目标翻译。这种“大一统”的设计极大地减少了信息损耗,确保了语义理解的连贯性和准确性,是真正的“图文音义”一体化理解。

突破瓶颈:「超感跨模态算法」解决了哪些传统翻译难题?

这项新技术的商业化应用,直接解决了用户在现实场景中遇到的诸多翻译痛点。无论是复杂的学术论文、格式多样的商业PPT,还是海外旅行时遇到的菜单路牌,它都提供了更优的解决方案。下面我们通过一个直观的对比来看看它究竟突破了哪些瓶颈:

| 翻译场景 | 传统翻译模型 | 有道「超感跨模态算法」 |

|---|---|---|

| 复杂文档(如PDF、PPT) | 翻译结果格式错乱,图片内文字无法翻译,图文对应关系丢失。 | 完整保留原始版式,精准翻译图片内文字,实现所见即所得的文档翻译。 |

| AR实景翻译(如菜单、路牌) | 仅对识别出的文字进行孤立翻译,可能因缺乏场景理解而出错(如将菜名“鱼香肉丝”直译)。 | 结合场景理解进行翻译,能识别出这是菜单,并给出更符合美食语境的翻译,效果更自然、精准。 |

| 语音同声传译 | 只能处理音频信息,无法理解演讲者配合的图表、手势等视觉信息。 | 具备结合视觉信息进行理解的潜力,能更准确地翻译与视觉元素相关的表达(如“这个增长曲线”)。 |

例如,在处理一份包含图表和复杂排版的商业报告时,传统翻译工具往往只能提取纯文本,导致最终译文的可读性极差。而「超感跨模态算法」能够完整解析整个页面的布局,将译文精准地放回原位,甚至翻译图片中的嵌入文字,实现“沉浸式”的文档阅读体验,这对于学术研究和商务沟通具有不可估量的价值。

技术揭秘:有道「子曰」大模型如何驱动这一创新?

如此强大的功能背后,是网易有道深厚的技术积累和前瞻性的战略布局。这项算法的成功,离不开其自研的教育大模型——“子曰”的强大驱动。

背后的引擎:「子曰」教育大模型的强大支撑

“子曰”是网易有道在2023年推出的业界首个教育领域垂直大模型。不同于通用大模型,“子曰”从诞生之初就专注于处理图文并茂的教材、带有公式的理科试卷、包含音视频的课程等复杂的教育场景数据。这种对多模态信息处理的天然亲和力,为「超感跨模态算法」的研发提供了最肥沃的土壤。可以说,正是“子曰”大模型在多模态理解能力上的深厚积淀,才催生了这一翻译领域的革命性技术。

创新的模型架构:实现多模态信息的端到端处理

在技术架构上,「超感跨模态算法」采用了一种创新的端到端多模态处理方案。该模型能够接收不同模态的输入(如图像像素、文本编码),并通过一个统一的注意力机制(Unified Attention Mechanism)来学习和融合这些信息。这意味着模型在翻译一个词时,不仅会“看”到它的上下文单词,还会“看”到它在图片中的位置、颜色、字体,甚至是周围的图像元素。这种一体化的处理方式,使得模型能够捕捉到更深层次的、跨越模态的语义关联,从而生成前所未有的高质量翻译结果。

实践出真知:新算法已在哪些有道产品中落地?

作为一家注重技术与产品紧密结合的公司,网易有道已迅速将「超感跨模态算法」的强大能力赋予其核心产品矩阵,让前沿科技真正服务于亿万用户。

- 有道翻译App: 全新的文档翻译功能和AR翻译功能已全面升级。用户上传一份PDF文件,即可获得一份保留原版式的精准译文;举起手机对准异国路牌,得到的不再是生硬的直译,而是结合场景的智能翻译。

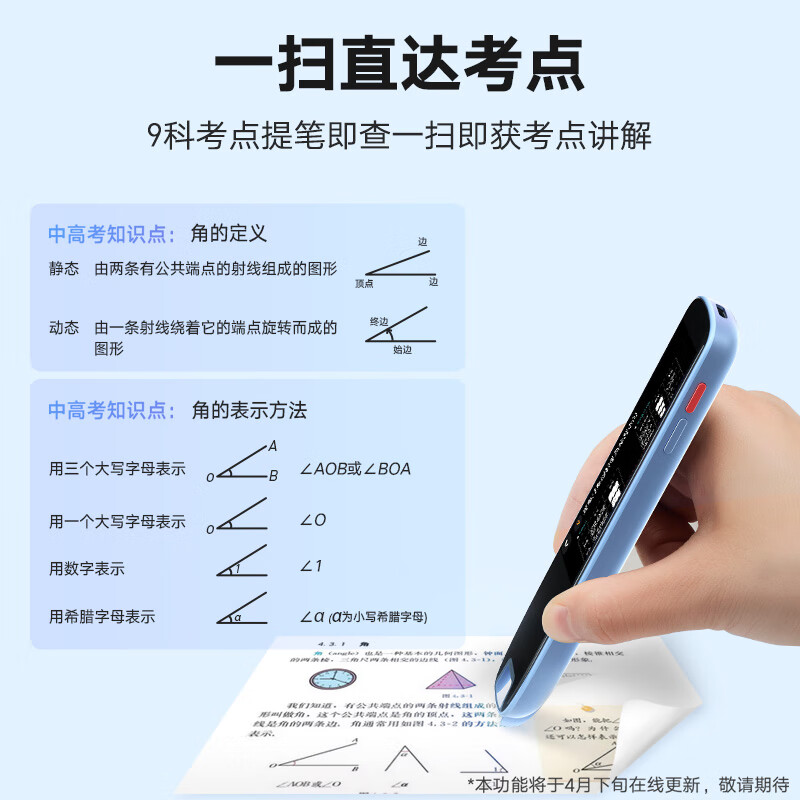

- 有道词典笔: 硬件产品同样受益。最新款的有道词典笔在扫描书本时,能够更好地处理图文混排的内容,即使是复杂的科普读物或漫画,也能提供流畅准确的翻译体验。

- 网页版有道翻译: 对于需要在电脑端处理大量文档的用户,网页版有道翻译同样提供了由新算法驱动的文档翻译服务,极大地提升了工作和学习效率。

这些产品的落地应用,不仅证明了算法的成熟度和商业价值,更体现了有道以用户为中心,用技术解决实际问题的坚定承诺。这为有道的产品建立了强大的技术壁垒,也为用户带来了实实在在的体验升级。

展望未来:跨模态技术将如何重塑AI翻译的版图?

「超感跨模态算法」的商用,不仅仅是有道自身的一次技术跃迁,更预示着整个AI翻译行业未来的发展方向。从文本到多模态,AI正在学会像人类一样去“看”和“听”,这为我们描绘了一幅激动人心的未来图景。

超越语言的障碍:迈向真正的“通用人工智能”

跨模态理解被认为是通向通用人工智能(AGI)的关键一步。当AI能够无缝地在视觉、听觉和语言之间切换和理解时,它将不再是一个简单的工具,而是一个能够与人类在更自然、更深层次上协作的智能伙伴。未来的翻译可能不再局限于文字,而是实现对整个视频内容的实时、精准翻译和配音,甚至是理解并转述非语言信息(如情绪、氛围),从而彻底打破文化与交流的壁垒。

有道在AI翻译赛道的雄心与未来布局

此次「超感跨模态算法」的发布,清晰地展示了网易有道在AI翻译赛道上的雄心与实力。依托其在教育领域的独特优势和“子曰”大模型的强大引擎,有道正走出一条差异化的创新之路。未来,可以预见有道将继续深化跨模态技术的研究,探索其在同声传译、虚拟人交互、智能教育等更多领域的应用。这不仅将持续巩固其在国内翻译市场的领先地位,也使其在全球AI技术竞赛中成为一个不容小觑的创新力量。从有道翻译出发,一个更加智能、更加“懂你”的AI时代正加速到来。