要爬虫有道翻译,需分析其API请求,用Python重现JS加密逻辑,生成动态的salt和sign参数,再通过requests库发送POST请求获取翻译结果。

文章目录

有道翻译反爬虫机制是什么?

直接通过程序请求有道翻译的接口通常会失败,因为其部署了复杂的反爬虫机制。与许多简单的网站不同,有道翻译并非直接通过一个公开的API提供服务。它在前端通过JavaScript动态生成一系列加密参数,服务器端会校验这些参数的有效性。如果请求中缺少这些参数或参数值不正确,服务器将拒绝响应。这种机制的核心在于验证请求是否来自官方的浏览器环境,而非自动化脚本。

理解这一机制是成功编写爬虫的第一步。其目的不是为了完全阻止开发者,而是为了防止服务被大规模、恶意的自动化程序滥用。因此,我们的任务就是模拟浏览器的行为,特别是复现其加密参数的生成过程。

第一步:分析浏览器网络请求

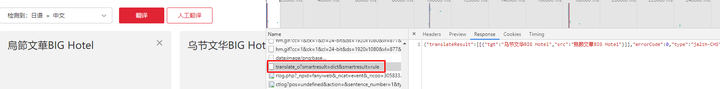

要破解其反爬虫机制,我们首先需要知道浏览器在翻译时究竟做了什么。打开有道翻译网站,按F12键打开开发者工具,并切换到“网络(Network)”面板。在输入框中输入任意需要翻译的词汇,例如“hello”,然后观察网络请求列表。

你会发现一个名为 `translate_o?…` 的请求,其类型为POST。这正是执行翻译功能的核心API请求。点击该请求,查看其“载荷(Payload)”或“Headers”中的表单数据(Form Data)。这里包含了发送给服务器的所有信息,是后续进行代码模拟的关键依据。

第二步:解密核心API参数

在`translate_o`请求的表单数据中,你会看到许多参数。其中一些是固定的或容易理解的,但有几个是动态变化的,它们是反爬虫的关键。

| 参数名 | 描述 | 是否为加密核心 |

|---|---|---|

i |

需要翻译的文本内容。 | 否 |

from |

源语言,如’AUTO’或’en’。 | 否 |

to |

目标语言,如’AUTO’或’zh-CHS’。 | 否 |

client |

客户端标识,通常是固定的’fanyideskweb’。 | 否 |

salt |

动态生成的随机“盐”值,通常是时间戳加上一个随机数。 | 是 |

sign |

签名,由客户端标识、待翻译文本、salt和一个固定密钥进行MD5加密生成。 | 是 |

lts |

时间戳,通常是13位的毫秒级时间戳。 | 是(与salt和sign关联) |

bv |

浏览器User-Agent的MD5值,用于标识客户端环境。 | 是(但相对固定) |

这里的核心挑战在于如何生成与每次请求都匹配的 `salt` 和 `sign`。`salt` 的随机性确保了每次请求的签名都不同,而 `sign` 则是服务器用来验证请求合法性的“密码”。如果无法正确生成这两个值,请求就会被视为无效。

如何用Python实现有道翻译爬虫?

知道了加密参数的构成后,下一步就是用Python代码来复现这个过程。这需要进行简单的 JavaScript逆向工程,即找到并读懂前端生成这些参数的JS代码,然后用Python翻译出来。这个方法效率最高,因为它直接与API交互,无需加载整个网页。

定位JavaScript加密源码

在开发者工具的“发起程序(Initiator)”或“调用堆栈(Call Stack)”中,可以追溯到是哪个JavaScript文件发起了`translate_o`请求。你也可以在“来源(Sources)”面板中全局搜索关键词,如`”fanyideskweb”`或`”translate_o”`,这通常能帮助你快速定位到相关的JS文件。

在混淆过的JS代码中,通过耐心分析,你会找到类似以下的逻辑:一个函数接收待翻译文本作为输入,结合当前时间戳、随机数等信息,通过一系列拼接和MD5加密操作,最终生成`salt`和`sign`。这个过程是固定的,因此可以被我们用其他语言重写。

在Python中重现salt与sign生成逻辑

通过分析JS源码可以得知,`salt`、`sign` 和 `lts` 的生成逻辑大致如下:

- `lts`: 当前的13位毫秒级时间戳。在Python中,可以通过 `int(time.time() * 1000)` 实现。

- `salt`: `lts` 加上一个0到9之间的随机整数。例如 `str(lts) + str(random.randint(0, 9))`。

- `sign`: 这是最关键的一步。它通常是将多个字符串拼接后进行MD5加密。根据当前版本的JS逻辑,其公式为 `md5(“fanyideskweb” + 待翻译文本 + salt + “特定密钥”)`。这个“特定密钥”是一个硬编码在JS文件中的字符串,需要你从源码中找到。

在Python中,我们可以使用`hashlib`库来实现MD5加密。整个逻辑清晰明了,只需确保每一步都与JS中的计算方式完全一致。

完整的Python requests实现代码

下面是一个结合了上述分析的完整Python脚本。它使用`requests`库发送POST请求,并动态计算所有必需的参数。

“`python

import requests

import time

import random

import hashlib

def get_youdao_translation(text):

“””

使用requests库获取有道翻译结果。

:param text: 需要翻译的文本

:return: 翻译结果的JSON数据或None

“””

# API请求地址

url = “https://fanyi.youdao.com/translate_o?smartresult=dict&smartresult=rule”

# 浏览器User-Agent

user_agent = “Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/99.0.4844.51 Safari/537.36”

# 计算lts, salt, sign

lts = str(int(time.time() * 1000))

salt = lts + str(random.randint(0, 9))

# 注意:这里的 ‘GOrs_VjZf_2Z_2z_3Ha)’ 是从JS源码中找到的密钥,它可能会改变

sign_str = “fanyideskweb” + text + salt + “GOrs_VjZf_2Z_2z_3Ha)”

# MD5加密

m = hashlib.md5()

m.update(sign_str.encode(‘utf-8’))

sign = m.hexdigest()

# 构建POST表单数据

data = {

‘i’: text,

‘from’: ‘AUTO’,

‘to’: ‘AUTO’,

‘smartresult’: ‘dict’,

‘client’: ‘fanyideskweb’,

‘salt’: salt,

‘sign’: sign,

‘lts’: lts,

‘bv’: hashlib.md5(user_agent.encode(‘utf-8’)).hexdigest(),

‘doctype’: ‘json’,

‘version’: ‘2.1’,

‘keyfrom’: ‘fanyi.web’,

‘action’: ‘FY_BY_REALTlME’,

}

# 设置请求头

headers = {

‘User-Agent’: user_agent,

‘Referer’: ‘https://fanyi.youdao.com/’,

‘Cookie’: ‘OUTFOX_SEARCH_USER_ID=-1234567890@10.169.0.83;’ # 简单的Cookie,有时需要

}

try:

response = requests.post(url, headers=headers, data=data)

response.raise_for_status() # 如果请求失败则引发HTTPError

return response.json()

except requests.exceptions.RequestException as e:

print(f”请求失败: {e}”)

return None

if __name__ == ‘__main__’:

word_to_translate = “web scraper”

result = get_youdao_translation(word_to_translate)

if result:

# 提取并打印翻译结果

translation = result.get(‘translateResult’, [[{}]])[0][0].get(‘tgt’, ‘翻译失败’)

print(f”‘{word_to_translate}’ 的翻译结果是: {translation}”)

“`

有更简单的采集方法吗?

对于不熟悉JavaScript逆向工程或只想快速实现少量数据采集的用户来说,存在一种更简单的方法:使用自动化测试工具 Selenium。Selenium可以驱动一个真实的浏览器(如Chrome或Firefox)来执行操作,包括打开网页、输入文本、点击按钮等。

这种方法的优点是无需关心底层的API和加密逻辑,因为所有操作都是在浏览器环境中完成的,JS代码会像正常用户访问一样自动执行。缺点是效率较低,因为它需要加载完整的网页,包括图片、CSS和所有JS脚本,资源消耗远大于直接的API请求。

什么时候选择Selenium?

- 快速原型验证: 当你只想快速验证翻译功能是否可以被自动化时。

- 少量数据采集: 如果你只需要翻译几十或几百个词条,Selenium的效率足够了。

- 避免JS逆向: 当API加密逻辑非常复杂或频繁变更,逆向成本过高时。

- 处理复杂交互: 如果获取翻译结果需要登录、点击多个按钮或处理弹窗,Selenium的优势就体现出来了。

使用Selenium获取翻译结果的示例

以下是使用Selenium和Python获取有道翻译结果的简单代码。你需要先安装`selenium`库和对应的浏览器驱动(如ChromeDriver)。

“`python

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

import time

def get_translation_with_selenium(text):

“””

使用Selenium驱动浏览器获取有道翻译结果。

“””

options = webdriver.ChromeOptions()

# options.add_argument(‘–headless’) # 无头模式,不在前台显示浏览器窗口

driver = webdriver.Chrome(options=options)

try:

driver.get(“https://fanyi.youdao.com/”)

# 定位输入框并输入文本

input_element = driver.find_element(By.ID, “input_original”)

input_element.send_keys(text)

# 等待翻译结果出现

# 注意:这里的选择器可能会因网站改版而变化

wait = WebDriverWait(driver, 10)

output_element = wait.until(

EC.presence_of_element_located((By.XPATH, ‘//*[@id=”trans_result”]/div[1]/p’))

)

# 等待文本内容稳定

time.sleep(1) # 增加短暂延时确保内容加载完毕

return output_element.text

finally:

driver.quit()

if __name__ == ‘__main__’:

word = “data integrity”

translation = get_translation_with_selenium(word)

if translation:

print(f”‘{word}’ 的翻译结果是: {translation}”)

“`

如何应对常见的爬虫挑战?

无论使用`requests`还是`Selenium`,在进行大规模或持续性的数据采集时,都会遇到一些共同的挑战。有效地应对这些问题是确保爬虫稳定可靠运行的关键。

处理IP封禁与请求频率限制

当你从同一个IP地址以极高的频率发送请求时,目标服务器的防火墙或安全策略会很快识别出你的行为是自动化脚本,并采取封禁措施。这通常表现为连接超时、返回错误代码(如403 Forbidden)或要求进行人机验证。

解决这一问题的最佳实践是使用代理IP池。通过轮换不同的IP地址发送请求,可以有效分散请求来源,模拟多个不同用户的正常访问行为。频繁的请求很容易触发有道翻译的IP封锁机制。为了确保爬虫的稳定运行和大规模数据采集,使用高质量的代理IP是至关重要的。例如,YOWDAO 提供的动态住宅代理可以有效模拟真实用户行为,大幅降低被封锁的风险,是进行商业级数据采集的理想选择。

除了使用代理,还应在代码中设置合理的请求间隔(例如,每次请求后随机暂停1-3秒),避免对目标服务器造成过大压力,这既是一种技术策略,也是一种网络礼仪。

应对API变更与代码维护

网站会定期更新,这些更新可能导致前端JS逻辑、API端点或加密参数(特别是`sign`签名中的固定密钥)发生变化。一旦发生变化,之前编写的爬虫脚本就会失效。因此,代码的长期维护是不可避免的。

为了应对这种情况,建议:

- 代码模块化: 将加密逻辑、网络请求、数据解析等功能封装成独立的函数或类,当某个部分失效时,只需修改对应模块,而无需重写整个脚本。

- 添加监控和警报: 设置一个简单的监控程序,定期运行爬虫并检查返回结果是否符合预期。如果连续多次失败,则通过邮件或即时消息发送警报,提示需要进行代码维护。

- 记录版本信息: 在代码注释中记录当前爬虫适配的网站版本或JS文件版本,当发现网站更新时,可以快速对比差异,定位问题。

常见问题解答

问:爬取有道翻译是否合法?

答:爬虫技术本身是中立的。但未经许可抓取网站数据可能违反该网站的服务条款(ToS)。用于个人学习和技术研究通常被认为是合理使用,但将抓取的数据用于商业目的或对服务器造成损害则存在法律风险。建议优先考虑使用官方提供的API服务。

问:为什么我的代码有时成功有时失败?

答:这通常由几个原因造成:1) IP被临时限制,需要等待或更换IP;2) Cookie问题,部分请求可能需要特定的Cookie信息才能成功;3) 有道翻译的A/B测试,服务器可能对不同用户展示不同的加密逻辑,导致你的单一破解方法失效;4) 请求频率过高触发了速率限制。

问:我能用这个方法翻译整个文件吗?

答:技术上可行,但强烈不建议。对单个接口进行高强度、大批量的调用极易被封禁,并且对服务器资源是一种滥用。对于大文本量的翻译需求,应当使用有道智云等官方提供的付费API服务,它们为批量处理提供了稳定、高效且合规的解决方案。

问:`sign`签名中的那个固定密钥字符串会变吗?

答:会的。这是网站开发者用来对抗爬虫的常用手段之一。他们会不定期地更换这个密钥。当你的爬虫突然失效时,这应该是你首先要检查的地方之一。你需要重新回到JS源码中寻找新的密钥字符串。